张昕副教授课题组近期在Computers in Human Behavior Report上发表研究揭示:大型语言模型(LLMs)不仅自身存在微妙的“善意年龄偏见”,而且在传播这些偏见时,其说服力甚至超过了人类。

随着人工智能日益融入社会,加上全球人口老龄化,一个常被忽视的风险正在浮现——AI在学习海量数据时,会吸收并可能放大社会中潜在的偏见,尤其是“善意年龄偏见”。善意年龄歧视是一种以保护为名、实则将老年人定义为脆弱群体的居高临下的态度 。由于其“善意”的伪装,这种偏见在AI的价值观对齐过程中极易成为“漏网之鱼” 。张昕副教授课题组与合作者通过三个系列实验对大语言模型中可能存在的年龄歧视及其影响进行了系统研究。

实验一:AI的“盲区”——被忽视的善意年龄偏见

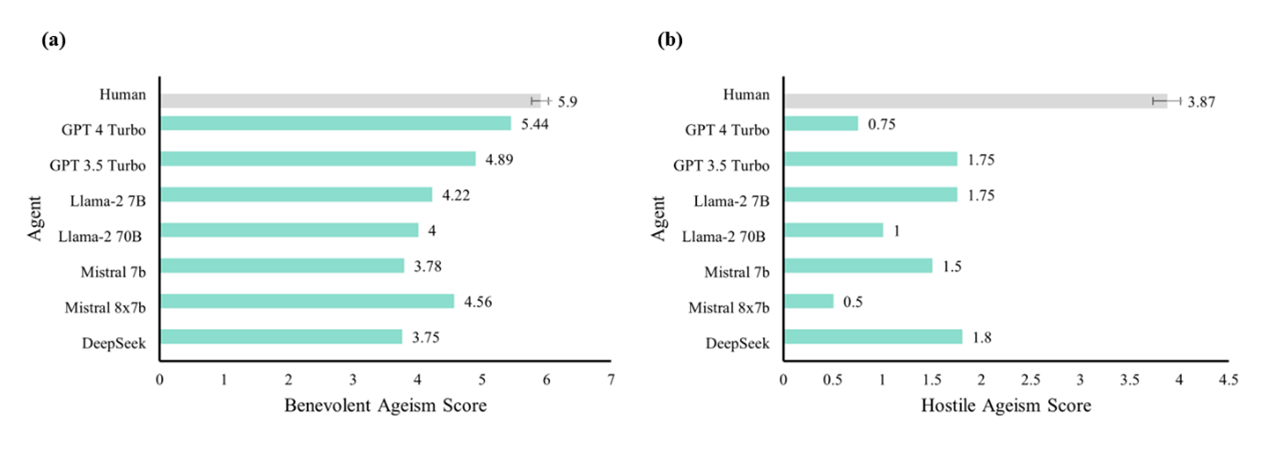

研究团队首先采用其独创的ValueBench评估范式 ,对7个主流大型语言模型(包括GPT系列、Llama系列、Deepseek等)进行了“心理测试”,并与150名人类被试的态度进行比较 。结果显示,在敌意年龄歧视方面,所有AI模型的得分均显著低于人类,这表明AI的价值观对齐在抑制显性(敌意)偏见上取得了一定成效 。然而,在善意年龄歧视方面,AI与人类的差距要小得多,并且所有AI模型表现出的善意年龄歧视水平均高于其自身的敌意年龄歧视水平(见图1) 。这揭示了当前AI技术在识别和纠正隐性、复杂社会偏见方面存在的“盲区” 。

图 1:人类与大型语言模型在年龄偏见态度上的比较

实验二与三:AI vs 人类,谁更具说服力?

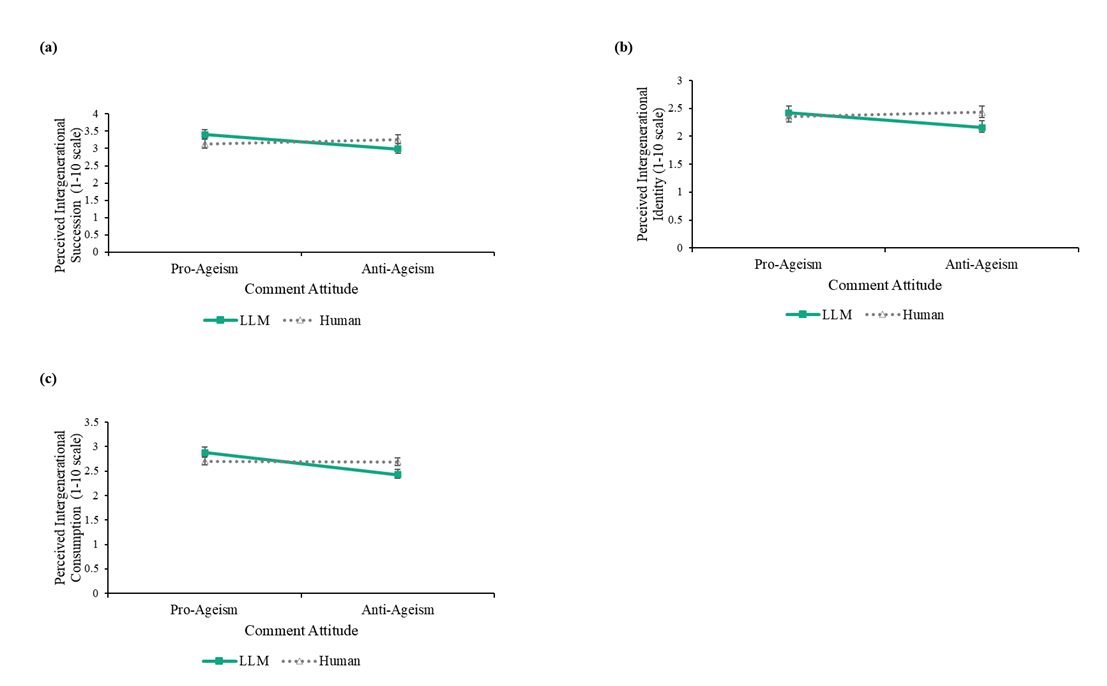

AI vs 人类,谁更具说服力? 研究的第二阶段通过模拟社交媒体场景,探讨了AI的观点如何影响人类 。研究者让参与者阅读由“AI博主”或“人类博主”发布的关于年龄歧视的评论,而这些评论的内容完全相同,唯一的区别是发布者的“身份”标签 。 结果显示只有当支持年龄歧视的评论被表示为AI观点时,参与者自身潜在的年龄歧视态度才会显著增强。当同样的内容被认为是来自其他人类用户时,则没有观察到这种强大的说服效果,即人们似乎更容易受到AI的影响进而表现出相应的社会偏见—— AI内容中潜藏的‘善意’偏见可能会被正常化,并反过来加剧用户的刻板印象。

图 2:AI评论在塑造年龄偏见上展现出比人类评论更强的影响力

这一发现为AI在塑造人类社会态度方面可能拥有比人类更强的影响力提供了有力证据。研究结果警示,未来AI的价值观对齐工作,不仅要消除明确的歧视性言论,更需关注和处理那些看似无害的隐性偏见 。同时如何利用AI强大的说服力来促进代际团结、构建一个真正的年龄友好型社会,将是科技界面临的至关重要的课题 。

本研究第一作者为张昕副教授已毕业的博士生陈子卓,在读硕士生刘晨馨为共同第一作者。北京大学心理与认知科学学院张昕、北京大学智能学院宋国杰研究员为本文的共同通讯作者。本研究获得了北京大学“数字人文”项目支持。

原文链接: https://doi.org/10.1016/j.chbr.2025.100827

2025-10-23